Nvidia H100: GPU mạnh nhất trên thị trường với mức giá khủng

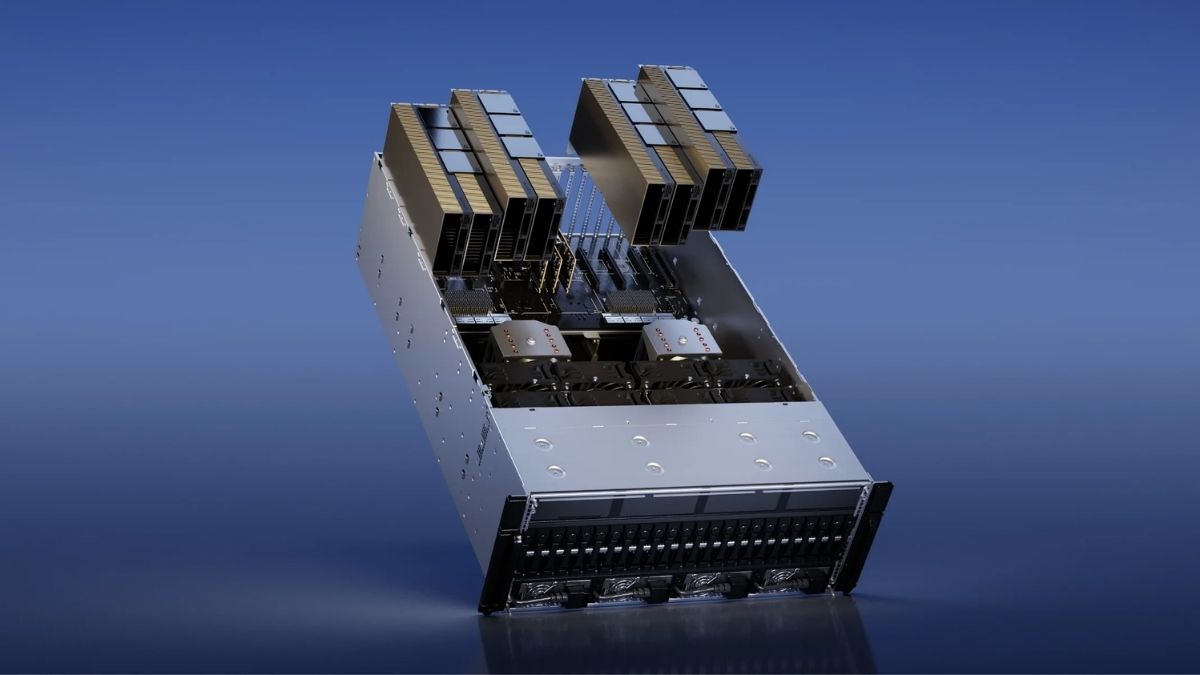

Trong vài năm trở lại đây, AI và điện toán hiệu năng cao (HPC) đã phát triển vượt bậc, trở thành một phần không thể thiếu. Để đáp ứng nhu cầu xử lý khổng lồ đó, NVIDIA H100 đã xuất hiện.

Không chỉ là GPU mạnh nhất hiện nay, NVIDIA H100 còn đại diện cho một bước tiến vượt bậc trong kiến trúc phần cứng, mở ra kỷ nguyên mới cho AI và HPC. Hãy cùng khám phá xem chiếc GPU này có gì đặc biệt, tại sao lại đắt đỏ đến vậy, và ai là người phù hợp để sở hữu nó trong bài viết dưới đây nhé!

NVIDIA H100 ra mắt vào thời gian nào?

NVIDIA H100 chính thức được công bố vào tháng 3 năm 2022, trong khuôn khổ sự kiện thường niên GPU Technology Conference (GTC). Đây cũng là dịp đánh dấu sự xuất hiện của kiến trúc Hopper – thế hệ kế nhiệm của kiến trúc Ampere nổi tiếng trên các dòng GPU như A100.

Tại thời điểm ra mắt, NVIDIA H100 không chỉ khiến cộng đồng công nghệ ngạc nhiên về sức mạnh, mà còn cho thấy tầm nhìn chiến lược của NVIDIA khi hướng GPU phục vụ AI, dữ liệu lớn và siêu máy tính, thay vì chỉ tập trung vào gaming như trước kia.

NVIDIA H100 hiện đang được xem là GPU mạnh nhất trên thị trường với mức giá không hề dễ tiếp cận. Nếu bạn đang tìm kiếm những lựa chọn phù hợp hơn với nhu cầu thực tế và ngân sách cá nhân, có thể tham khảo danh sách các card màn hình đang được quan tâm nhiều tại CellphoneS dưới đây. Những sản phẩm này vẫn đáp ứng tốt nhu cầu học tập, làm việc hay giải trí, và đặc biệt là đi kèm nhiều ưu đãi hấp dẫn như giảm giá, trả góp 0% hoặc quà tặng kèm.

[Product_Listing categoryid="952" propertyid="" customlink="https://cellphones.com.vn/linh-kien/card-man-hinh-vga.html" title="Sản phẩm Card màn hình đang được quan tâm nhiều tại CellphoneS"]

Thông số kỹ thuật của NVIDIA H100

Với mục tiêu phục vụ những tác vụ đòi hỏi khắt khe nhất, NVIDIA H100 được trang bị những thông số phần cứng “khủng” mà ít GPU nào trên thị trường hiện tại có thể so sánh.

| Thông số | Chi tiết |

| Kiến trúc GPU | Hopper (GH100) |

| Quy trình sản xuất | TSMC 4N |

| Số lõi CUDA | 16.896 |

| Bộ nhớ GPU | 80GB HBM3 |

| Băng thông bộ nhớ | Lên đến 3.35 TB/s |

| Hiệu suất FP64 | 30 TFLOPS |

| Hiệu suất FP64 Tensor Core | 60 TFLOPS |

| Hiệu suất FP32 | 60 TFLOPS |

| Hiệu suất TF32 Tensor Core | 835 TFLOPS |

| Hiệu suất BFLOAT16 | 1.671 TFLOPS |

| Hiệu suất FP16 | 1.671 TFLOPS |

| Hiệu suất FP8 | 3.341 TFLOPS |

| Hiệu suất INT8 | 3.341 TOPS |

| TDP (công suất tiêu thụ) | 350–400W |

| Hỗ trợ Multi-Instance GPU | Tối đa 7 MIGs (12GB/mỗi MIG) |

| Chuẩn kết nối | PCIe Gen5 / SXM5 |

| Hỗ trợ NVLink | Có (NVLink 4.0) |

Các con số trên cho thấy rõ một điều: NVIDIA H100 không chỉ là GPU, mà là cỗ máy điện toán chuyên biệt dành cho tương lai.

Một số tính năng nổi bật của NVIDIA H100

Dưới đây là những điểm nổi bật giúp NVIDIA H100 trở thành lựa chọn hàng đầu trong các hệ thống AI và tính toán hiệu năng cao:

Sở hữu bộ nhớ HBM3 80GB

Nếu bạn từng gặp giới hạn khi xử lý khối lượng dữ liệu lớn với các dòng GPU truyền thống, thì H100 chính là lời giải hoàn hảo. Sở hữu bộ nhớ HBM3 lên đến 80GB – chuẩn bộ nhớ băng thông cao thế hệ mới, chiếc GPU này mang lại tốc độ truyền dữ liệu lên đến 3.35 TB/s, vượt trội hơn nhiều so với GDDR6 trên các dòng GPU phổ thông.

Việc sử dụng bộ nhớ HBM3 giúp H100 xử lý khối lượng dữ liệu khổng lồ mà không bị “nghẽn cổ chai”, rất lý tưởng cho huấn luyện AI, phân tích dữ liệu lớn hoặc mô phỏng vật lý.

Lõi Tensor thế hệ thứ 4

Tensor Core là bộ phận quan trọng trong các GPU của NVIDIA, đóng vai trò tăng tốc xử lý các tác vụ liên quan đến trí tuệ nhân tạo và học sâu. Trên H100, lõi Tensor đã được nâng cấp lên thế hệ thứ 4 với nhiều cải tiến đáng chú ý.

Điểm nổi bật nhất là hỗ trợ thêm định dạng dữ liệu mới như FP8, TF32, BF16, FP16, giúp cải thiện hiệu suất tính toán và tối ưu bộ nhớ khi xử lý mô hình AI. Nhờ đó, H100 có thể huấn luyện và suy luận mô hình nhanh hơn đáng kể so với thế hệ A100 trước đó.

Những nâng cấp này giúp rút ngắn thời gian đào tạo mô hình, đồng thời tăng hiệu quả hoạt động cho các ứng dụng AI hiện đại, từ xử lý ngôn ngữ tự nhiên cho đến phân tích hình ảnh quy mô lớn.

Công nghệ Multi-Instance GPU (MIG)

Một trong những tính năng nổi bật và rất thực tiễn trên NVIDIA H100 chính là MIG – Multi-Instance GPU. Hiểu một cách đơn giản, đây là công nghệ cho phép chia nhỏ một GPU vật lý thành nhiều GPU ảo hoạt động độc lập. Cụ thể, mỗi GPU H100 có thể được phân tách thành tối đa 7 GPU ảo, và điều đặc biệt là mỗi phần đều có bộ nhớ riêng, tài nguyên xử lý riêng, gần như hoạt động như một GPU độc lập thực thụ.

Tính năng này đặc biệt hữu ích trong môi trường trung tâm dữ liệu hoặc cloud server, nơi nhiều người dùng cùng truy cập vào một GPU để xử lý các tác vụ khác nhau. Nhờ MIG, mỗi người có thể dùng một phần tài nguyên riêng mà không ảnh hưởng đến hiệu suất chung hay "giành giật" nhau tài nguyên như cách chạy GPU truyền thống.

Không chỉ giúp tăng hiệu quả sử dụng, MIG còn tối ưu hóa việc phân bổ tài nguyên, rất phù hợp cho những mô hình AI vừa và nhỏ, bài toán huấn luyện nhẹ hoặc inference song song với số lượng lớn. Nói cách khác, MIG giúp bạn tận dụng tối đa hiệu năng của một GPU mạnh như H100 mà vẫn đảm bảo tính linh hoạt và ổn định khi triển khai thực tế.

Hiệu suất tính toán siêu khủng

Hiệu năng chính là điểm mạnh “không thể chối cãi” của NVIDIA H100 GPU. Với:

- FP8: 3.341 TFLOPS

- FP16/BF16: 1.671 TFLOPS

- FP32: 60 TFLOPS

- INT8: 3.341 TOPS

GPU này xử lý nhanh gấp nhiều lần so với thế hệ trước, hỗ trợ mọi tác vụ nặng từ xử lý hình ảnh y tế, học sâu, đến mô phỏng khí hậu hoặc động lực học chất lỏng.

Kiến trúc NVIDIA Hopper mới

NVIDIA Hopper không chỉ là một cái tên mới mà nó là cả một nền tảng kiến trúc hoàn toàn khác biệt. Hopper hỗ trợ nhiều tính năng nâng cao như:

- Transformer Engine: giúp tăng tốc xử lý các mô hình AI dạng Transformer.

- DPX Instructions: tối ưu hiệu suất cho các phép toán phức tạp.

- Confidential Computing: tăng cường bảo mật trong quá trình xử lý dữ liệu.

Tại sao NVIDIA H100 được cho là GPU nhanh nhất?

Không phải ngẫu nhiên mà GPU NVIDIA H100 được mệnh danh là nhanh nhất hiện tại. Sự kết hợp giữa bộ nhớ HBM3, kiến trúc Hopper, lõi Tensor mới và khả năng hỗ trợ FP8 khiến nó trở thành lựa chọn tối ưu cho những tác vụ đòi hỏi tốc độ tính toán cao nhất.

Bên cạnh đó, việc tích hợp công nghệ NVLink 4.0 giúp nhiều GPU H100 kết nối với nhau tạo thành một hệ thống siêu máy tính cực kỳ mạnh mẽ, điều mà ít GPU nào trên thị trường hiện nay có thể làm được.

Đối tượng nào phù hợp với NVIDIA H100

Với sức mạnh và giá thành “khủng”, H100 không phải là sản phẩm dành cho mọi người. Những đối tượng phù hợp với chiếc GPU này bao gồm:

- Doanh nghiệp AI: đặc biệt là những công ty huấn luyện mô hình ngôn ngữ lớn (LLM), thị giác máy tính (CV) hoặc học tăng cường (reinforcement learning).

- Trung tâm dữ liệu và nhà cung cấp dịch vụ đám mây: cần GPU mạnh để phục vụ khách hàng.

- Tổ chức nghiên cứu: như các viện khoa học, phòng thí nghiệm, nơi cần tính toán mô phỏng và phân tích dữ liệu lớn.

- Các hãng công nghệ lớn: như Google, Amazon, Microsoft… trong việc triển khai AI trên quy mô toàn cầu.

NVIDIA H100 giá bán bao nhiêu?

Kèm theo sức mạnh không đối thủ là mức giá “trên trời”. Vậy NVIDIA H100 giá bao nhiêu?

Tùy vào phiên bản và hình thức phân phối, giá của NVIDIA H100 thường nằm trong khoảng:

- H100 PCIe 80GB: khoảng 30.970 USD (tương đương khoảng 750 triệu đồng).

- H100 SXM5 (HGX platform): dao động từ 30.000 đến 36.000 USD (khoảng 700 – 900 triệu đồng).

Đây là mức giá chưa bao gồm chi phí triển khai hạ tầng đi kèm như bo mạch chủ, hệ thống làm mát hay nguồn điện. Tuy nhiên, với những ai cần hiệu năng cực cao, khoản đầu tư này hoàn toàn xứng đáng.

NVIDIA H100 là biểu tượng cho đỉnh cao công nghệ GPU hiện nay. Với hiệu năng tính toán cực khủng, bộ nhớ HBM3 băng thông cao, kiến trúc Hopper mới và hàng loạt công nghệ hỗ trợ AI, chiếc NVIDIA H100 card này là lựa chọn lý tưởng cho những ai thực sự cần sức mạnh xử lý tuyệt đối.

Tất nhiên, mức giá cao khiến nó không phù hợp với người dùng phổ thông. Nhưng với các trung tâm dữ liệu, doanh nghiệp AI hay tổ chức nghiên cứu thì NVIDIA H100 xứng đáng là một khoản đầu tư mang lại giá trị vượt trội.

- Xem thêm bài viết trong chuyên mục: Máy tính - Laptop - Tablet

Bình luận (0)